O Novo Alinhamento do iPad e Acessórios na Apple: Uma Visão Detalhada

Quais são as novas atrações da “Let Loose” da Apple? O recente evento “Let Loose”...

Quais são as novas atrações da "Let Loose" da Apple? O recente evento "Let Loose" da Apple foi palco para...

Recentemente, uma notícia significativa marcou as manchetes envolvendo a popular plataforma de vídeos curtos, TikTok, e o governo dos Estados...

Em um evento recente focado em suas últimas inovações, a Apple introduziu ao mundo o revolucionário chip M4, prometendo elevar...

O que há de tão especial no novo Snapdragon X Plus? A indústria de tecnologia está sempre em movimento, e...

Explorar a diversidade e as funcionalidades avançadas da linha Samsung Galaxy nunca foi tão acessível. Com descontos significativos disponíveis na...

Quais são as novas atrações da “Let Loose” da Apple? O recente...

Recentemente, uma notícia significativa marcou as manchetes envolvendo a popular plataforma de...

Em um evento recente focado em suas últimas inovações, a Apple introduziu...

O que há de tão especial no novo Snapdragon X Plus? A...

Explorar a diversidade e as funcionalidades avançadas da linha Samsung Galaxy nunca...

A Vivo, uma das principais fabricantes de smartphones, acaba de lançar dois...

Acompanhe em tempo real as principais novidades do mundo tech.

Quais são as novas atrações da “Let Loose” da Apple? O recente evento “Let Loose”...

Recentemente, uma notícia significativa marcou as manchetes envolvendo a popular plataforma de vídeos curtos, TikTok,...

Em um evento recente focado em suas últimas inovações, a Apple introduziu ao mundo o...

O que há de tão especial no novo Snapdragon X Plus? A indústria de tecnologia...

Explorar a diversidade e as funcionalidades avançadas da linha Samsung Galaxy nunca foi tão acessível....

A Vivo, uma das principais fabricantes de smartphones, acaba de lançar dois novos modelos de...

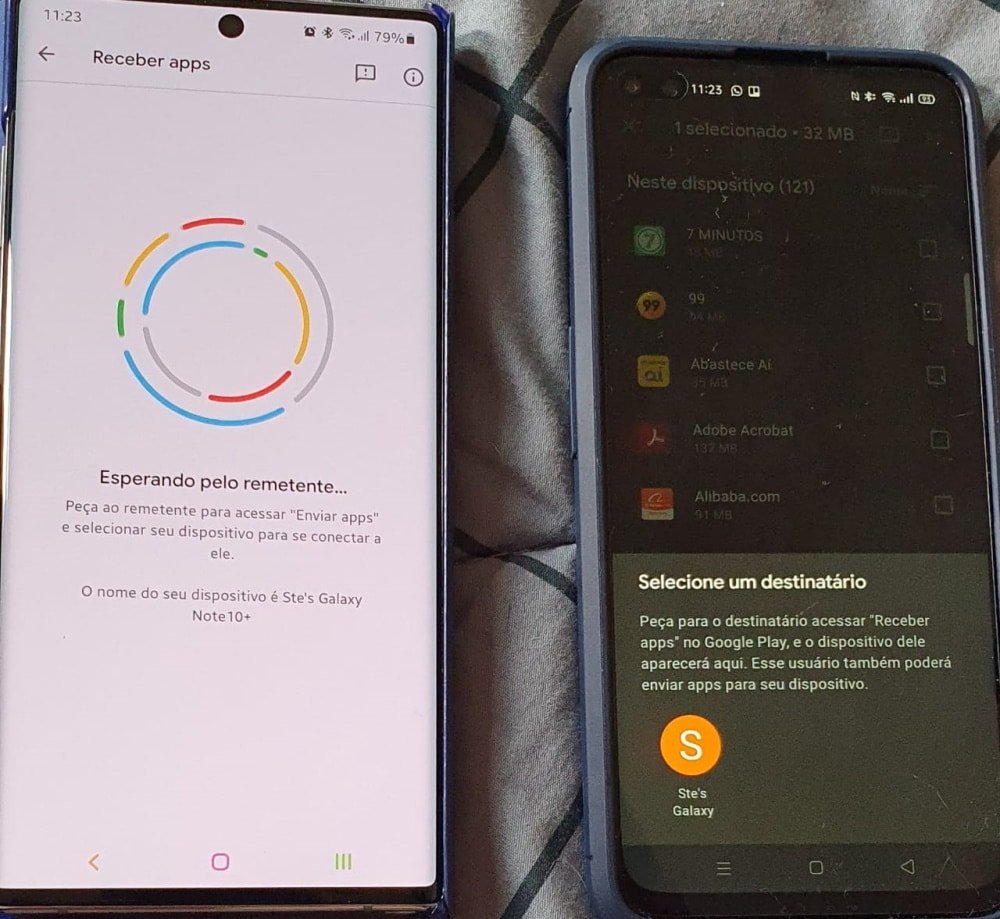

O ecossistema Android está constantemente evoluindo, e uma das áreas que tem recebido atenção especial...

Recentemente, temos observado uma série de inovações no segmento de smartphones, especialmente nos modelos de...

Acesse uma seleção de smartphones em oferta na Amazon e aproveite para comprar o seu...

TVs 4K da Samsung estão em oferta na Amazon; confira uma seleção de modelos e...

Confira nossa seleção especial de TVs em promoção na Amazon e garanta até 34% off!...

Os smartphones dobráveis da Samsung estão em oferta na Amazon; confira e aproveite para economizar...

7 apps ou sites para quem quer vender produtos

7 apps para editar suas fotos do Instagram

Galaxy Z Fold3 5G e Galaxy Z Flip3 5G lançados, saiba tudo sobre eles

Possível Z Roll, extensível da Samsung, aparece em patente

Os melhores vídeos sobre tecnologia

Navegue pelas principais editorias

Conteúdo selecionado para você