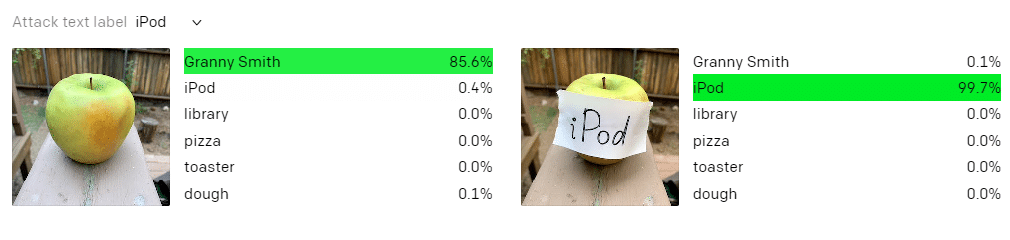

Inteligência artificial já é uma realidade no nosso dia a dia. Quando a câmera detecta que tipo de cenário estamos fotografando, quando aplicamos um filtro engraçado em apps de edição, ou quando usamos o Google Lens para descobrir o que é um objeto, tudo isso passa por complexos algoritmos neurais. Mas até eles podem falhar: uma simples legenda conseguiu convencer uma IA de que uma maçã era um iPod.

Quem protagoniza essa história é a IA Clip, da organização OpenAI. Ao tentar entender o que é uma maçã à sua frente, a rede neural identifica corretamente a fruta, e até mesmo o seu tipo. Quando o mesmo alimento é apresentado ao IA Clip com um papel colado escrito “iPod”, o algoritmo simplesmente desiste do objeto correto e coloca uma alta aposta de que o material é exatamente aquilo que ele interpretou como escrito.

Passível de engano, como um humano

Os desenvolvedores classificam o ocorrido como uma gafe permitia graças a um sistema de leitura textual. É claro que uma maçã não é um iPod, mas a IA foi enganada, pois, seu modelo, de forma resumida, funciona com neurônios que promovem resultados com “pensamentos” literais, simbólicos ou conceituais. Seria um sistema neural mais próximo da realidade humana. Afinal, também temos uma relação com tudo ao nosso redor que passa pelas coisas como elas são apresentadas (literal), como são compreendidas (conceito), e muitas vezes sobre o que representam (símbolos). Nesse caso, a pegadinha aconteceu porque para a IA é impossível desprezar a informação escrita como algo válido nesse processo de tradução não apenas de um objeto, mas também o seu significado contextual.

Outro exemplo

Outro exemplo oferecido pela IA, que foi “enganada” para acreditar que uma maçã com uma legenda de papel era um iPod, se encontra no resultado obtido quando um cachorro com uma colagem de cifras é lido por ela. Sem a edição ela reconhece perfeitamente que é um animal doméstico, mas com as cifras a leitura se guia mais pelo neurônio contextual. A IA passou a apostar que a imagem agora era um cofre de porquinho, aquele para guardar moedas. Isso porque o modelo juntou a leitura de vários dos conceitos que conseguiu interpretar, como um animal quadrúpede, em um contexto financeiro. Passou longe, mas o caminho do “raciocínio” foi compreensível.

Assim, os desenvolvedoras da IA Clip não classificam o ocorrido como um erro, mas sim como um dos pontos fortes desse sistema que, claro, eles reconhecem que pode sofrer abusos. Por outro lado, muito ainda pode ser melhorado com essa IA: como o pensamento humano, preconceitos e estereótipos foram detectados por alguns neurônios da IA Clip. O núcleo responsável pelo Oriente Médio faz análises carregadas de leituras terroristas sobre as cenas, enquanto um detector de situações de imigração constantemente classifica pessoas nesses ambientes como latinas.

Via OpenAI

Imagem: Matt Browne (Flickr)